1. Giới thiệu

Trong bối cảnh trí tuệ nhân tạo (AI) phát triển nhanh chóng, khả năng kết nối các mô hình ngôn ngữ lớn (LLM) với các công cụ và nguồn dữ liệu bên ngoài ngày càng trở nên quan trọng. Model Context Protocol (MCP), một tiêu chuẩn mở do Anthropic giới thiệu, nhằm mục đích giải quyết thách thức này bằng cách chuẩn hóa cách các ứng dụng AI tương tác với các hệ thống bên ngoài. Đồng thời, n8n đã nổi lên như một nền tảng tự động hóa quy trình công việc mạnh mẽ, linh hoạt, đặc biệt phù hợp với việc tích hợp các công nghệ AI mới nổi nhờ kiến trúc mã nguồn mở và khả năng mở rộng.

Báo cáo này phân tích sâu về Model Context Protocol (MCP), khám phá định nghĩa, kiến trúc, các thành phần cốt lõi và cơ chế hoạt động của nó. Tiếp theo, báo cáo sẽ đi sâu vào nền tảng n8n, các tính năng tự động hóa và khả năng tích hợp AI của nó, đặc biệt là mô hình "Nodes as Tools". Trọng tâm chính là phân tích các chiến lược tích hợp giữa MCP và n8n, bao gồm việc sử dụng các nút cộng đồng như n8n-nodes-mcp, cấu hình, các trường hợp sử dụng thực tế, lợi ích và thách thức. Cuối cùng, báo cáo sẽ so sánh cách tiếp cận sử dụng MCP trong n8n với các phương pháp tích hợp AI khác có sẵn trên nền tảng, đưa ra các khuyến nghị chiến lược cho các nhóm kỹ thuật đang tìm cách tận dụng MCP trong hệ sinh thái n8n.

2. Tìm hiểu Model Context Protocol (MCP) của Anthropic

2.1. Định nghĩa, Mục đích và Khái niệm Cốt lõi

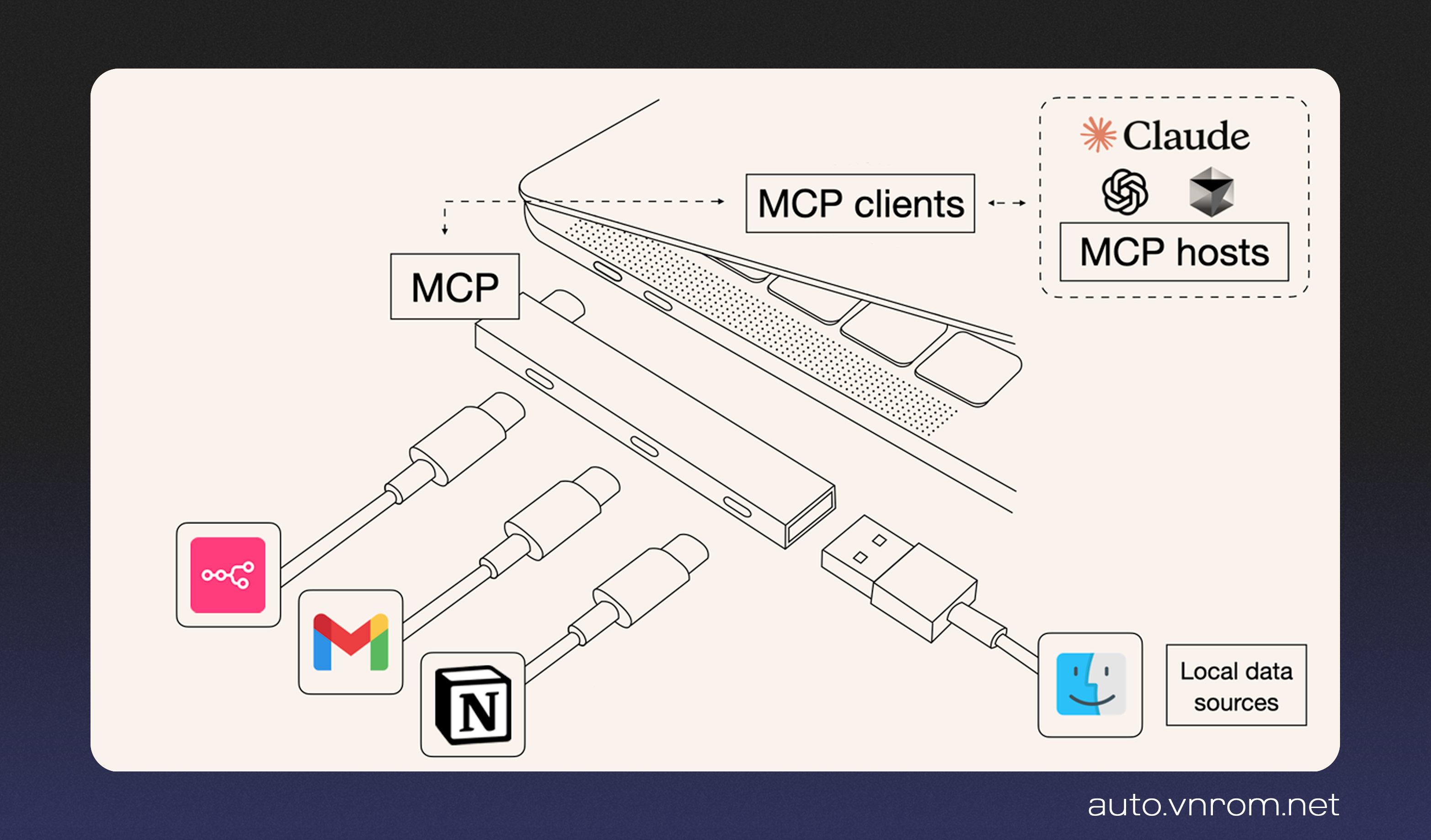

Model Context Protocol (MCP) là một tiêu chuẩn mở được Anthropic phát triển và công bố vào cuối năm 2024, với mục tiêu chính là chuẩn hóa cách các ứng dụng AI, đặc biệt là các trợ lý AI và LLM, kết nối và tương tác với các hệ thống bên ngoài. Các hệ thống này bao gồm kho lưu trữ nội dung, công cụ kinh doanh, môi trường phát triển, cơ sở dữ liệu và các API khác.

Mục đích cốt lõi của MCP là giải quyết vấn đề cô lập dữ liệu của các mô hình AI, ngay cả những mô hình tinh vi nhất cũng bị hạn chế bởi sự tách biệt khỏi các nguồn thông tin và hệ thống kế thừa. Trước MCP, việc tích hợp mỗi nguồn dữ liệu mới đòi hỏi một triển khai tùy chỉnh, tạo ra sự phân mảnh và khó khăn trong việc mở rộng quy mô các hệ thống AI thực sự được kết nối. MCP giải quyết thách thức này bằng cách cung cấp một giao thức chung, mở, thay thế các tích hợp phân mảnh bằng một tiêu chuẩn duy nhất, tương tự như cách USB-C chuẩn hóa kết nối cho các thiết bị ngoại vi. Kết quả là một cách đơn giản hơn, đáng tin cậy hơn để cung cấp cho các hệ thống AI quyền truy cập vào dữ liệu và công cụ chúng cần, cho phép chúng tạo ra các phản hồi tốt hơn, phù hợp hơn và cập nhật hơn.

Việc Anthropic không chỉ công bố đặc tả mà còn cung cấp SDK (Python, TypeScript, và sau này là Java, Kotlin, C#), hỗ trợ máy chủ cục bộ trong ứng dụng Claude Desktop và một kho lưu trữ mã nguồn mở các máy chủ MCP mẫu (cho Google Drive, Slack, GitHub, Git, Postgres, Puppeteer) cho thấy đây không chỉ là một đề xuất lý thuyết. Đây là một động thái chiến lược nhằm thúc đẩy việc áp dụng và xây dựng một hệ sinh thái xung quanh giao thức, thể hiện cam kết về sự phát triển và tiềm năng lâu dài của MCP.

2.2. Kiến trúc MCP: Clients, Servers và Giao tiếp

MCP hoạt động dựa trên kiến trúc client-server. Kiến trúc này bao gồm ba thành phần chính:

- Host: Là ứng dụng chính chứa và điều phối các thành phần khác, ví dụ như một môi trường phát triển tích hợp (IDE), một ứng dụng chatbot như Claude Desktop, hoặc một hệ thống AI tùy chỉnh. Host quản lý các client, điều phối tương tác với LLM, kiểm soát quyền kết nối của client, vòng đời và thực thi các chính sách bảo mật cũng như yêu cầu sự đồng ý của người dùng.

- Client: Nằm bên trong Host, mỗi client duy trì một kết nối trạng thái (stateful) 1:1 với một server duy nhất. Client chịu trách nhiệm xử lý việc đàm phán giao thức, khám phá khả năng của server, định tuyến thông điệp hai chiều (yêu cầu và phản hồi), quản lý đăng ký và thông báo, đồng thời duy trì ranh giới bảo mật giữa các server.

- Server: Đóng vai trò là "thông dịch viên" hoặc cầu nối/API wrapper cho một hệ thống bên ngoài cụ thể (API, cơ sở dữ liệu, tệp cục bộ, v.v.). Server phơi bày các khả năng của hệ thống đó (dưới dạng tools, resources, prompts) theo đặc tả MCP cho client.

Giao tiếp giữa client và server dựa trên giao thức JSON-RPC 2.0.2 MCP hỗ trợ hai cơ chế vận chuyển (transport) chính:

- STDIO (Standard Input/Output): Được sử dụng khi client và server chạy trên cùng một máy. Cơ chế này đơn giản và hiệu quả cho các tích hợp cục bộ, ví dụ như truy cập tệp cục bộ hoặc chạy một script cục bộ. Việc sử dụng STDIO thường ngụ ý rằng tiến trình MCP server được khởi chạy và quản lý trực tiếp bởi client (hoặc Host thông qua client).

- HTTP với Server-Sent Events (SSE): Được sử dụng cho giao tiếp có thể diễn ra từ xa hoặc tách biệt giữa client và server. Server duy trì một kết nối SSE liên tục để đẩy thông điệp (sự kiện) đến client; client sử dụng các yêu cầu HTTP POST tiêu chuẩn để gửi lệnh đến server. Cơ chế này cho phép kiến trúc phân tán với nhiều client đồng thời và phù hợp hơn cho các server được lưu trữ độc lập. Việc sử dụng SSE ngụ ý rằng server có thể chạy độc lập, có khả năng ở xa.

Vòng đời kết nối giữa client và server bao gồm ba giai đoạn chính: Khởi tạo (Initialization - bắt tay, trao đổi phiên bản giao thức và khả năng), Hoạt động (Operation - giao tiếp giao thức bình thường diễn ra), và Đóng kết nối (Shutdown - kết thúc kết nối một cách duyên dáng).

Sự lựa chọn giữa cơ chế vận chuyển STDIO và SSE có những tác động đáng kể đến kiến trúc triển khai, bảo mật và khả năng mở rộng khi tích hợp MCP vào các nền tảng như n8n. STDIO có thể đơn giản hơn cho việc thử nghiệm cục bộ nhưng khó mở rộng hoặc bảo mật hơn trong môi trường sản xuất, trong khi SSE cung cấp sự linh hoạt triển khai cao hơn nhưng đòi hỏi phải quản lý vòng đời của server một cách riêng biệt.

2.3. Các Thành phần Cốt lõi: Tools, Resources và Prompts

MCP server phơi bày ba loại khả năng (capabilities) chính cho các client AI:

- Tools (Công cụ - Model kiểm soát): Đây là các hàm (functions) hoặc hành động (actions) mà LLM có thể quyết định gọi để thực hiện các tác vụ cụ thể. Chúng tương tự như cơ chế function calling trong các API LLM khác. Ví dụ bao gồm truy vấn cơ sở dữ liệu, tìm kiếm trên web, gửi tin nhắn qua Slack, hoặc thực hiện các lệnh hệ thống. Server cung cấp tên, mô tả (rất khuyến khích) và lược đồ đầu vào (input schema) cho mỗi tool để LLM biết cách sử dụng.

- Resources (Tài nguyên - Ứng dụng kiểm soát): Đây là các nguồn dữ liệu mà LLM có thể truy cập để lấy ngữ cảnh (context). Chúng thường là dữ liệu chỉ đọc (read-only), không thực hiện tính toán đáng kể và không gây ra tác dụng phụ (side effects). Ví dụ bao gồm các đoạn tài liệu, đoạn mã, nội dung tệp, hoặc bản ghi cơ sở dữ liệu. Dữ liệu từ Resources được cung cấp như một phần của ngữ cảnh hoặc yêu cầu cho LLM.

- Prompts (Lời nhắc - Người dùng kiểm soát): Đây là các mẫu (templates) hoặc hướng dẫn được định nghĩa trước nhằm hướng dẫn mô hình sử dụng Tools hoặc Resources một cách tối ưu nhất. Chúng có thể được coi là các lời nhắc được lưu trữ hoặc macro. Prompts thường được người dùng lựa chọn trước khi thực hiện suy luận (inference).

Các thành phần này cho phép AI (thông qua Host/Client) khám phá và sử dụng các khả năng của server một cách có cấu trúc. Sự phân biệt rõ ràng giữa Tools (hành động có thể gây tác dụng phụ) và Resources (dữ liệu chỉ đọc) mang lại sự tách biệt rõ ràng hơn về mối quan tâm so với cơ chế function calling chung chung, có khả năng cải thiện khả năng kiểm soát và bảo mật. Host có thể cho phép truy cập Resources tự do hơn so với Tools. Prompts bổ sung một lớp nữa, cho phép người dùng hoặc nhà phát triển đóng gói các mẫu tương tác phổ biến, giảm bớt gánh nặng cho LLM trong việc tìm ra cách tối ưu để sử dụng tool/resource mỗi lần. Cách tiếp cận có cấu trúc này có thể dẫn đến các hệ thống agentic đáng tin cậy và an toàn hơn.

3. n8n: Nền tảng Tự động hóa AI-Native

3.1. Tổng quan về Tính năng Tự động hóa Quy trình Công việc của n8n

n8n là một công cụ tự động hóa quy trình công việc (workflow automation) dựa trên giao diện trực quan và các nút (nodes). Nền tảng này nổi bật với giấy phép fair-code, mã nguồn mở và khả năng tự lưu trữ (self-hosting), mang lại cho người dùng sự kiểm soát hoàn toàn đối với dữ liệu, hành vi hệ thống và việc triển khai.

n8n có khả năng mở rộng cao thông qua việc cho phép người dùng viết các hàm tùy chỉnh bằng JavaScript hoặc Python trong Code node và hỗ trợ cài đặt các nút tùy chỉnh do cộng đồng phát triển (community nodes). Nền tảng này cung cấp hơn 400 tích hợp sẵn có (integrations) với các ứng dụng và dịch vụ phổ biến.

Các khái niệm cốt lõi của n8n bao gồm:

- Workflows: Chuỗi các bước tự động hóa được biểu diễn trực quan trên canvas. Workflows là các đối tượng hạng nhất, có thể được tạo, phiên bản hóa, chia sẻ và nhập lại.

- Nodes: Các khối xây dựng cơ bản của workflow, đại diện cho một bước hoặc hành động cụ thể. Có hai loại chính:

- Triggers: Khởi động workflow dựa trên các sự kiện hoặc điều kiện cụ thể (ví dụ: webhook, lịch trình, sự kiện ứng dụng).

- Actions: Thực hiện các tác vụ như gọi API, chuyển đổi dữ liệu, gửi thông báo.

- Connections: Liên kết giữa các node, xác định luồng dữ liệu.

- Credentials: Lưu trữ thông tin xác thực (API keys, mật khẩu) một cách an toàn để kết nối với các dịch vụ bên ngoài.

- Executions: Một lần chạy cụ thể của một workflow.

Các điểm mạnh cốt lõi của n8n – tính linh hoạt, khả năng mở rộng (thông qua code nodes và community nodes), và khả năng self-hosting – làm cho nó đặc biệt phù hợp để tích hợp và thử nghiệm các công nghệ AI mới nổi như MCP. So với các nền tảng tự động hóa SaaS cứng nhắc hơn, kiến trúc của n8n vốn hỗ trợ loại thử nghiệm và thiết lập tùy chỉnh cần thiết để áp dụng một giao thức như MCP.

3.2. Tích hợp AI: Nodes Tích hợp sẵn, Agents và Hỗ trợ LangChain

n8n tích hợp các khả năng AI một cách sâu sắc vào nền tảng của mình. Các tính năng AI chính bao gồm:

- Nodes AI Tích hợp sẵn: Cung cấp các node để tương tác trực tiếp với các dịch vụ AI phổ biến như OpenAI, Anthropic Chat Model, các mô hình nhúng (embeddings), và các kho lưu trữ vector (vector stores). Điều này cho phép người dùng dễ dàng thêm các khả năng AI vào quy trình công việc của họ.

- AI Agents: n8n giới thiệu khái niệm AI Agents, được xây dựng dựa trên framework LangChain. Các agent này có khả năng thực hiện lý luận đa bước, sử dụng các công cụ (tools) bên ngoài và duy trì bộ nhớ (memory) qua các lượt hội thoại. Ban đầu, n8n cung cấp nhiều loại agent khác nhau (ví dụ: Conversational, Tools, SQL), nhưng sau đó đã đơn giản hóa, tập trung chủ yếu vào "Tools Agent" như là loại agent mặc định và được khuyến nghị.

- Hỗ trợ LangChain: Ngoài AI Agent node trực quan, n8n còn cung cấp LangChain Code node, cho phép các nhà phát triển triển khai các logic LangChain tùy chỉnh phức tạp hơn bằng code.

Chiến lược AI của n8n tập trung vào việc trừu tượng hóa các framework phức tạp như LangChain thành các node trực quan, dễ tiếp cận. Điều này cho phép người dùng xây dựng các ứng dụng AI tinh vi một cách trực quan mà không cần viết nhiều code, trong khi vẫn giữ được sức mạnh của công nghệ nền tảng. Việc này hạ thấp rào cản gia nhập cho việc xây dựng các quy trình công việc agentic so với việc lập trình trực tiếp bằng LangChain.

3.3. Mô hình "Nodes as Tools" cho AI Agents

Một tính năng quan trọng trong hệ sinh thái AI của n8n là "Nodes as Tools", được giới thiệu vào khoảng phiên bản 1.62.1.51 Tính năng này cho phép các node n8n tiêu chuẩn (ban đầu là một tập hợp con gồm 22 dịch vụ, chủ yếu tập trung vào công cụ năng suất và lưu trữ, nhưng sau đó được mở rộng) được sử dụng trực tiếp làm công cụ (tools) cho AI Agent node.

Cách hoạt động:

- Người dùng có thể chọn các node n8n được hỗ trợ trong phần cấu hình "Tools" của AI Agent node.

- AI Agent (sử dụng LLM) có thể hiểu khả năng của các node này (dựa trên mô tả của chúng) và quyết định khi nào cần gọi chúng để thực hiện một tác vụ hoặc lấy thông tin.

- Biểu thức $fromAI() mới được giới thiệu cho phép AI Agent tự động điền các tham số động cho các node công cụ này dựa trên ngữ cảnh hội thoại.

Tính năng này đơn giản hóa đáng kể quá trình xây dựng agent so với các phương pháp trước đó, chẳng hạn như sử dụng các tool sub-node chuyên dụng hoặc phải đóng gói toàn bộ workflow khác làm công cụ tùy chỉnh. Nó tạo cảm giác "tự nhiên" hơn khi làm việc trong môi trường n8n.

Sự ra đời của "Nodes as Tools" thể hiện tiêu chuẩn tích hợp công cụ AI đang phát triển của chính n8n. Nó cung cấp một giải pháp thay thế trực tiếp và tích hợp sẵn cho việc sử dụng các tiêu chuẩn bên ngoài như MCP bên trong môi trường n8n, đặc biệt đối với các chức năng đã có sẵn dưới dạng node n8n. Điều này tạo ra một sự lựa chọn cho người dùng: tận dụng hệ sinh thái MCP rộng lớn hơn thông qua community node, hoặc sử dụng cách tiếp cận n8n gốc đơn giản hơn cho các node được hỗ trợ. Tiêu chuẩn nội bộ này cạnh tranh trực tiếp với lý do sử dụng MCP trong n8n cho nhiều trường hợp sử dụng phổ biến.

4. Kết nối MCP và n8n: Các Chiến lược Tích hợp

4.1. Tận dụng Community Nodes: Hệ sinh thái n8n-nodes-mcp

Cách chính để tích hợp chức năng client của Model Context Protocol (MCP) vào n8n là thông qua các nút cộng đồng (community nodes). Nút nổi bật nhất cho mục đích này là n8n-nodes-mcp. Tuy nhiên, cần lưu ý rằng có thể tồn tại các biến thể hoặc nhánh (forks) của nút này với các tên gọi hoặc nhà phát hành khác nhau (ví dụ: có hậu tố -client, hoặc do nerding-io, couleetech, illuminaresolutions, makafeli phát hành).

Việc này nhấn mạnh bản chất cộng đồng của tích hợp MCP hiện tại trong n8n. Sự tồn tại của nhiều nhánh/phiên bản cho thấy sự phát triển tích cực nhưng cũng tiềm ẩn sự phân mảnh và gây khó khăn cho người dùng khi lựa chọn gói phù hợp. Thiếu một triển khai chính thức duy nhất có thể dẫn đến sự khác biệt về tính năng, lỗi hoặc mức độ bảo trì. Người dùng cần đánh giá cẩn thận phiên bản nào phù hợp nhất với nhu cầu của họ.

Quá trình cài đặt nút này có thể được thực hiện thông qua giao diện quản lý Community Nodes trong n8n hoặc bằng cách sử dụng npm trực tiếp trên máy chủ n8n (đối với các bản tự lưu trữ). Sau khi cài đặt, nút MCP Client sẽ xuất hiện trong danh sách các node có sẵn để thêm vào workflow.

Để khám phá các MCP server có sẵn, người dùng có thể tham khảo các thư mục trực tuyến như mcp.so, Glama, mcpsvr.com, hoặc smithery.ai.

4.2. Cấu hình Chi tiết: Thiết lập, Credentials và Transports (STDIO/SSE)

Việc cấu hình nút n8n-nodes-mcp đòi hỏi thiết lập thông tin xác thực (credentials) cho từng MCP server mà người dùng muốn kết nối. Nút này hỗ trợ hai loại kết nối/vận chuyển (transport) chính, tương ứng với các cơ chế giao tiếp của MCP:

- STDIO (Command-line Based Transport):

- Cấu hình: Yêu cầu người dùng cung cấp Command (lệnh để khởi động MCP server, ví dụ: npx) và Arguments (các đối số cho lệnh đó, ví dụ: -y @modelcontextprotocol/server-brave-search).

- Biến môi trường: Có thể truyền các biến môi trường cần thiết cho MCP server thông qua giao diện cấu hình Credentials (định dạng NAME=VALUE) hoặc thông qua các biến môi trường của Docker (với tiền tố MCP_) khi triển khai n8n bằng Docker. Các biến này được lưu trữ an toàn dưới dạng credentials trong n8n hoặc được quản lý tập trung trong cấu hình Docker.

- Hoạt động: Khi sử dụng STDIO, n8n (thông qua nút MCP Client) sẽ khởi chạy tiến trình MCP server khi cần thiết. Điều này đơn giản hóa việc thiết lập cho thử nghiệm cục bộ.

- SSE (Server-Sent Events):

- Cấu hình: Yêu cầu người dùng cung cấp SSE URL (địa chỉ điểm cuối SSE của MCP server, ví dụ: http://localhost:3001/sse), Messages Post Endpoint (tùy chọn, điểm cuối tùy chỉnh để gửi tin nhắn) và Additional Headers (ví dụ: để xác thực).

- Hoạt động: Cơ chế này được sử dụng để kết nối với các MCP server đã chạy độc lập, có thể ở xa. Nó đòi hỏi việc triển khai và quản lý vòng đời của MCP server một cách riêng biệt.

Việc cấu hình credentials cho STDIO về cơ bản gói gọn việc quản lý vòng đời MCP server bên trong quá trình thực thi của nút n8n, trong khi SSE tách rời nó ra. Điều này có ý nghĩa quan trọng đối với việc quản lý tài nguyên và độ phức tạp của việc triển khai. STDIO có thể gây ra chi phí khởi động/tắt server cho mỗi lần thực thi hoặc sử dụng credential, và yêu cầu n8n có quyền truy cập vào npx hoặc tệp thực thi của server. SSE cho phép các server chạy liên tục, có khả năng mang lại hiệu suất tốt hơn (không có độ trễ khởi động) và tách biệt rõ ràng hơn các mối quan tâm, nhưng đòi hỏi nỗ lực quản lý server riêng. Lựa chọn phụ thuộc nhiều vào cơ sở hạ tầng và sở thích vận hành của người dùng.

4.3. Sử dụng các Hoạt động của n8n-nodes-mcp trong Workflows

Nút n8n-nodes-mcp client cung cấp một tập hợp các hoạt động (operations) tương ứng trực tiếp với các khả năng của giao thức MCP.13 Các hoạt động chính bao gồm:

- List Tools: Lấy danh sách các công cụ có sẵn từ MCP server được kết nối.

- Execute Tool: Thực thi một công cụ cụ thể với các tham số được cung cấp.

- List Resources: Lấy danh sách các tài nguyên có sẵn.

- Read Resource: Đọc nội dung của một tài nguyên cụ thể bằng URI của nó.

- List Prompts: Lấy danh sách các lời nhắc mẫu có sẵn.

- Get Prompt: Lấy nội dung của một lời nhắc mẫu cụ thể.

Các hoạt động này cung cấp một giao diện tương đối thấp cấp (low-level) để tương tác với MCP server từ bên trong quy trình công việc n8n. Người thiết kế workflow cần quản lý luồng tương tác, ví dụ, gọi List Tools trước nếu cần, sau đó mới gọi Execute Tool với tên công cụ và tham số phù hợp.

Ví dụ Workflow Đơn giản (Sử dụng Brave Search):

- Thêm Node MCP Client (Credential Brave Search): Cấu hình credential STDIO với lệnh npx và đối số -y @modelcontextprotocol/server-brave-search, cùng với BRAVE_API_KEY trong biến môi trường.

- Chọn Operation List Tools: Chạy node này để xem công cụ brave_search có sẵn.

- Thêm Node MCP Client thứ hai (Credential Brave Search):

- Chọn Operation Execute Tool:

- Tool Name: Chọn brave_search.

- Parameters: Đặt một đối tượng JSON, ví dụ: {"query": "latest AI news"}.

- Chạy Workflow: Node thứ hai sẽ thực thi tìm kiếm và trả về kết quả trong đầu ra của nó.

Cách tiếp cận này cho thấy nút MCP Client hoạt động như một cầu nối trực tiếp đến MCP, đòi hỏi người dùng hiểu các khái niệm của giao thức để sử dụng hiệu quả.

4.4. Kích hoạt MCP Nodes (và Community Nodes khác) làm AI Agent Tools

Để sử dụng nút n8n-nodes-mcp (hoặc bất kỳ community node nào khác) làm công cụ (tool) cho AI Agent node trong n8n, người dùng cần thực hiện một bước cấu hình bổ sung: đặt biến môi trường N8N_COMMUNITY_PACKAGES_ALLOW_TOOL_USAGE thành true.

Cách đặt biến môi trường:

- Shell (bash/zsh): export N8N_COMMUNITY_PACKAGES_ALLOW_TOOL_USAGE=true trước khi chạy n8n start.

- Docker/Docker Compose: Thêm vào phần environment của dịch vụ n8n trong tệp docker-compose.yml: - N8N_COMMUNITY_PACKAGES_ALLOW_TOOL_USAGE=true.

- Ứng dụng Desktop: Cần tìm cách cấu hình biến môi trường cho ứng dụng, có thể khác nhau tùy hệ điều hành.

Ngoài ra, bản thân mã nguồn của community node cũng cần được đánh dấu với thuộc tính usableAsTool: true (điều này liên quan đến nhà phát triển node, nhưng cung cấp ngữ cảnh quan trọng).

Sau khi biến môi trường được đặt và n8n khởi động lại, nút MCP Client (đã được cấu hình với credential phù hợp) sẽ xuất hiện trong danh sách lựa chọn khi người dùng nhấp vào nút "+" trong phần "Tools" của AI Agent node.

Nếu cấu hình này không được thực hiện đúng cách, người dùng có thể gặp lỗi như "Unrecognized node type: n8n-nodes-mcp.mcpClientTool" khi cố gắng sử dụng nút làm công cụ cho agent.

Việc yêu cầu bật cờ môi trường này cho thấy n8n coi việc cho phép community node làm công cụ agent là một cổng kiểm soát có chủ ý về bảo mật hoặc ổn định. Ban đầu, chỉ các core node mới được phép làm công cụ, và việc hỗ trợ community node được thêm vào sau nhưng yêu cầu sự đồng ý rõ ràng từ quản trị viên hệ thống. Người dùng phải chủ động kích hoạt tính năng này, chấp nhận mọi rủi ro hoặc sự không ổn định tiềm ẩn liên quan đến các thành phần không phải cốt lõi.

4.5. Xu hướng Mới nổi: n8n như một MCP Server

Ngoài vai trò chính là client tiêu thụ các MCP server, một xu hướng mới nổi là sử dụng chính n8n như một MCP server. Ý tưởng này là phơi bày các chức năng của workflow n8n cho các MCP client bên ngoài (như Claude Desktop, các ứng dụng AI khác) tuân theo chuẩn MCP.

Một số dự án cộng đồng đã bắt đầu khám phá hướng đi này, tạo ra các MCP server đóng gói (wrap) các API của n8n:

- leonardsellem/n8n-mcp-server

- illuminaresolutions/n8n-mcp-server

- makafeli/n8n-workflow-builder

Các server này cho phép các trợ lý AI tương tác với các instance n8n để:

- Liệt kê, tạo, cập nhật, xóa workflows.

- Kích hoạt, hủy kích hoạt workflows.

- Thực thi workflows (qua API hoặc webhook) và theo dõi trạng thái.

- Truy cập thông tin workflow, thống kê thực thi.

- Quản lý credentials, tags (một số yêu cầu bản Enterprise).

Lợi ích tiềm năng của việc này là rất lớn: tận dụng khả năng kết nối rộng rãi và logic workflow phức tạp của n8n, đóng gói chúng dưới dạng các công cụ tuân thủ chuẩn MCP để các hệ thống AI khác có thể dễ dàng sử dụng. Ví dụ, Claude Desktop có thể trực tiếp gọi và thực thi các workflow n8n phức tạp như những công cụ riêng của mình, mở rộng đáng kể khả năng của Claude mà không cần Anthropic phải xây dựng tích hợp riêng cho từng chức năng trong n8n.

Mặc dù hướng tích hợp này còn non trẻ hơn so với việc sử dụng n8n làm client, nó đại diện cho một sự mở rộng tiềm năng đáng kể vai trò của n8n trong hệ sinh thái AI, biến n8n thành một nhà cung cấp các hành động AI-callable được tiêu chuẩn hóa.

5. Triển khai Thực tế: MCP và n8n trong Hành động

5.1. Xây dựng AI Agents Nâng cao với MCP Tools trong n8n

Việc tích hợp MCP tools vào AI Agent node của n8n cho phép xây dựng các tác nhân tự động hóa thông minh hơn, có khả năng tương tác với thế giới bên ngoài thông qua một giao thức chuẩn hóa. Quá trình này bao gồm nhiều bước cấu hình:

- Chuẩn bị MCP Server: Đảm bảo MCP server cho công cụ mong muốn (ví dụ: Brave Search, GitHub, hoặc một công cụ tùy chỉnh) đang chạy và có thể truy cập được (qua STDIO hoặc SSE).

- Cài đặt n8n-nodes-mcp: Cài đặt community node này vào instance n8n.

- Cấu hình Credentials: Tạo một credential MCP Client trong n8n cho mỗi MCP server, cung cấp thông tin kết nối cần thiết (lệnh/đối số cho STDIO, URL/headers cho SSE) và biến môi trường.

- Kích hoạt Community Tools: Đặt biến môi trường N8N_COMMUNITY_PACKAGES_ALLOW_TOOL_USAGE=true cho instance n8n.

- Cấu hình AI Agent Node:

- Sử dụng loại agent "Tools Agent" (thường là mặc định trong các phiên bản mới).

- Trong phần "Tools", nhấp vào "+" và chọn "MCP Client".

- Chọn credential MCP Client tương ứng đã tạo ở bước 3. Lặp lại bước này cho mỗi MCP tool/server muốn cung cấp cho agent.

- Thiết kế Prompt: Cung cấp một "System Message" rõ ràng cho AI Agent, mô tả mục tiêu tổng thể và hướng dẫn cách sử dụng các công cụ có sẵn. Mô tả của từng công cụ (được lấy từ MCP server thông qua nút MCP Client) rất quan trọng để agent biết khi nào nên gọi công cụ nào.64

- Chạy và Gỡ lỗi: Cung cấp đầu vào cho agent (ví dụ: qua Chat Trigger) và theo dõi quá trình thực thi. Agent sẽ phân tích yêu cầu, quyết định (nếu cần) sử dụng công cụ nào dựa trên mô tả, gọi hoạt động Execute Tool của nút MCP Client tương ứng với các tham số được suy ra, nhận kết quả và tiếp tục xử lý hoặc trả lời người dùng.41

Ví dụ Conceptual Multi-Tool Agent (Lập kế hoạch chuyến đi):

Dựa trên ví dụ:

- Agent Prompt: "Tôi cần bạn giúp lập kế hoạch cho một chuyến đi đến {country}. Đầu tiên, tìm kiếm các điểm đến phổ biến ở đó. Sau đó, kiểm tra thời tiết hiện tại ở 3 thành phố hàng đầu. Cuối cùng, tìm một số tin tức gần đây về các hạn chế đi lại đối với những nơi này."

- Tools (MCP Clients được thêm vào Agent):

- MCP Client 1 (Credential Brave Search): Cung cấp công cụ brave_search.

- MCP Client 2 (Credential Weather API): Cung cấp công cụ get_weather.

- MCP Client 3 (Credential News API - giả định): Cung cấp công cụ search_news.

- Quá trình thực thi (lý tưởng):

- Agent nhận prompt.

- Agent gọi brave_search với query liên quan đến "popular destinations in {country}".

- Agent nhận kết quả, xác định 3 thành phố hàng đầu.

- Agent gọi get_weather lần lượt cho từng thành phố.

- Agent gọi search_news với query liên quan đến "travel restrictions" cho các thành phố đó.

- Agent tổng hợp thông tin và trả lời người dùng.

Việc sử dụng thành công MCP tools với n8n agents đòi hỏi sự phối hợp cẩn thận giữa việc thiết lập MCP server, cấu hình nút n8n-nodes-mcp, kích hoạt community tools và thiết kế prompt hiệu quả. Đây là một quy trình thiết lập đa lớp, và sự cố ở bất kỳ bước nào cũng có thể dẫn đến lỗi hoặc agent không sử dụng công cụ như mong đợi.

5.2. Ví dụ Workflow và Trường hợp Sử dụng

Các ví dụ thực tế về việc sử dụng n8n-nodes-mcp chủ yếu tập trung vào các MCP server công khai, dễ truy cập:

- Tìm kiếm Web Đơn giản:

- Mục tiêu: Thực hiện tìm kiếm web bằng Brave Search từ bên trong n8n.

- Workflow:

- Node bắt đầu (ví dụ: Manual Trigger hoặc Set để định nghĩa query).

- Node MCP Client (Credential Brave Search): Operation Execute Tool, Tool Name brave_search, Parameters {"query": "{{ $json.searchInput }}"}.

- Tham khảo:.13 Đây là ví dụ cơ bản nhất, minh họa việc gọi một tool cụ thể.

- Tương tác với Server SSE Cục bộ:

- Mục tiêu: Kết nối với một MCP server tùy chỉnh đang chạy cục bộ và sử dụng giao thức SSE.

- Workflow:

- Khởi chạy MCP server cục bộ hỗ trợ SSE (ví dụ: npx @modelcontextprotocol/server-example-sse trên port 3001).

- Node MCP Client: Connection Type Server-Sent Events (SSE), cấu hình credential SSE với URL http://localhost:3001/sse

- Chọn Operation List Tools hoặc Execute Tool tùy thuộc vào server mẫu.

- Tham khảo: Ví dụ này hữu ích khi server chạy như một dịch vụ độc lập hoặc yêu cầu xác thực qua header.

- Agent Đa Công cụ (Conceptual):

- Mục tiêu: Xây dựng agent có khả năng sử dụng nhiều công cụ từ các MCP server khác nhau (ví dụ: tìm kiếm, thời tiết, tin tức như mô tả ở phần 6.1).

- Workflow:

- Chat Trigger để nhận yêu cầu người dùng.

- AI Agent Node (Tools Agent).

- Thêm nhiều "MCP Client" vào phần Tools, mỗi cái được cấu hình với credential của một MCP server khác nhau (Brave Search, Weather, News, OpenAI, v.v.).

- Cấu hình System Message để hướng dẫn agent cách phối hợp các công cụ.

- Node phản hồi (ví dụ: trả lời lại Chat Trigger).

- Tham khảo: Ví dụ này thể hiện tiềm năng của MCP trong việc cung cấp một bộ công cụ đa dạng cho agent.

- Các Trường hợp Sử dụng Conceptual Khác:

- Quản lý Tệp: Sử dụng MCP server cho hệ thống tệp để agent có thể đọc, ghi, liệt kê tệp trên máy chủ (yêu cầu MCP server tương ứng).

- Tương tác Slack/GitHub: Sử dụng MCP server cho Slack hoặc GitHub để agent có thể gửi tin nhắn, đọc kênh, quản lý issue/repo (yêu cầu MCP server tương ứng).

- Truy vấn Cơ sở dữ liệu: Sử dụng MCP server cho Postgres hoặc cơ sở dữ liệu khác để agent truy vấn thông tin (yêu cầu MCP server tương ứng).

- Tự động hóa Trình duyệt: Sử dụng MCP server cho Puppeteer hoặc Playwright để agent điều khiển trình duyệt, trích xuất dữ liệu web (yêu cầu MCP server tương ứng).

Các ví dụ cụ thể, được ghi nhận trong tài liệu của n8n-nodes-mcp và các hướng dẫn liên quan, chủ yếu xoay quanh các server công khai như Brave Search. Việc áp dụng MCP cho các tác vụ phức tạp hơn hoặc các công cụ tùy chỉnh đòi hỏi người dùng phải tìm kiếm hoặc tự xây dựng MCP server tương ứng, đây là một bước phức tạp hơn đáng kể so với việc chỉ sử dụng nút n8n.

6. Phân tích: Ưu điểm và Hạn chế của MCP trong Hệ sinh thái n8n

6.1. Lợi ích: Tiêu chuẩn hóa, Khả năng mở rộng, Tương lai hóa

Việc tích hợp Model Context Protocol (MCP) vào n8n mang lại một số lợi ích tiềm năng đáng kể:

- Tiêu chuẩn hóa: MCP cung cấp một ngôn ngữ hoặc giao thức chung, thay thế nhu cầu tích hợp tùy chỉnh cho mỗi sự kết hợp giữa công cụ và mô hình AI. Điều này giúp đơn giản hóa quá trình phát triển, tích hợp và bảo trì các hệ thống AI phức tạp. Thay vì đối mặt với bài toán tích hợp "M×N" (M ứng dụng AI, N công cụ), MCP hướng tới mô hình "M+N", nơi mỗi bên chỉ cần tuân thủ giao thức một lần.

- Khả năng mở rộng (Extensibility): Bằng cách sử dụng nút n8n-nodes-mcp, các workflow và agent n8n có khả năng khai thác một hệ sinh thái MCP server đang phát triển do các bên thứ ba xây dựng, vượt ra ngoài các tích hợp sẵn có hoặc community node của n8n. Điều này mở ra khả năng truy cập vào các công cụ chuyên biệt hoặc nguồn dữ liệu cục bộ thông qua các MCP server tương ứng mà không cần phải chờ đợi hoặc tự xây dựng node n8n riêng.

- Khả năng tương tác (Interoperability): MCP tạo điều kiện giao tiếp giữa các ứng dụng AI và công cụ khác nhau tuân thủ cùng một tiêu chuẩn, thúc đẩy một môi trường workflow kết nối và hiệu quả hơn.

- Linh hoạt: Về lý thuyết, việc sử dụng một chuẩn chung như MCP có thể giúp việc chuyển đổi giữa các nhà cung cấp LLM hoặc các ứng dụng host (nếu chúng đều hỗ trợ MCP) trở nên dễ dàng hơn.

- Tách biệt rõ ràng: Giao thức phân biệt rõ ràng giữa việc truy cập dữ liệu (Resources) và thực hiện hành động (Tools), có khả năng tăng cường kiểm soát và bảo mật.

Lợi ích lý thuyết chính của việc sử dụng MCP trong n8n là khả năng tận dụng một hệ sinh thái công cụ bên ngoài, tiềm năng lớn và đa dạng, thông qua một điểm tích hợp duy nhất, được tiêu chuẩn hóa (nút n8n-nodes-mcp). Thay vì phụ thuộc hoàn toàn vào các tích hợp gốc của n8n hoặc phải xây dựng các node tùy chỉnh cho mọi thứ, MCP hứa hẹn một cách tiếp cận mô-đun và có khả năng mở rộng hơn để kết nối AI với thế giới bên ngoài.

6.2. Thách thức: Độ trưởng thành, Độ phức tạp, Gỡ lỗi, Hiệu suất

Mặc dù có nhiều hứa hẹn, việc triển khai MCP trong n8n cũng đối mặt với những thách thức và hạn chế đáng kể:

- Độ trưởng thành: MCP là một giao thức tương đối mới (ra mắt cuối năm 2024). Hệ sinh thái các server và client vẫn đang trong giai đoạn phát triển ban đầu. Việc áp dụng rộng rãi và hỗ trợ lâu dài chưa được đảm bảo.

- Độ phức tạp:

- Hiểu biết: Đòi hỏi người dùng phải hiểu các khái niệm của MCP (client, server, primitives, transports).

- Thiết lập và Quản lý: Việc thiết lập và quản lý MCP server (đặc biệt là tự lưu trữ hoặc qua STDIO) làm tăng thêm chi phí vận hành. Cấu hình bao gồm nhiều lớp: nút n8n, credentials, biến môi trường, và có thể cả cấu hình của MCP server.

- Phụ thuộc vào Cộng đồng: Tích hợp chính (n8n-nodes-mcp) là một community node 13, có thể thiếu sự ổn định, kiểm thử toàn diện và hỗ trợ đảm bảo như các tính năng cốt lõi của n8n.31 Sự tồn tại của nhiều phiên bản/nhánh cũng gây khó khăn.

- Gỡ lỗi (Debugging): Việc xác định và sửa lỗi có thể rất khó khăn, vì sự cố có thể xảy ra ở bất kỳ đâu trong chuỗi tương tác: workflow n8n -> nút n8n-nodes-mcp -> cơ chế transport (STDIO/SSE) -> MCP server -> công cụ/API nền tảng -> phản hồi ngược lại qua chuỗi. Thông báo lỗi có thể chung chung hoặc không rõ ràng.

- Hiệu suất:

- STDIO: Có chi phí khởi tạo tiến trình cho mỗi lần gọi.

- SSE: Bị ảnh hưởng bởi độ trễ mạng.

- Tương tác phức tạp: Có thể yêu cầu nhiều lượt trao đổi thông điệp giữa client và server.

- Độ tin cậy của AI Agent: Giống như với các công cụ gốc, AI agent có thể gặp khó khăn trong việc lựa chọn và sử dụng MCP tools một cách đáng tin cậy (ví dụ: chọn sai công cụ, tạo đầu vào không đúng định dạng, đạt giới hạn lặp). Điều này đòi hỏi việc thiết kế prompt cẩn thận và mô tả công cụ rõ ràng.

- Hạn chế của n8n: Các hạn chế chung của n8n vẫn áp dụng, chẳng hạn như giới hạn bộ nhớ khi xử lý lượng lớn dữ liệu, giới hạn thực thi trên các gói cloud, hoặc khó khăn trong việc gỡ lỗi các luồng phức tạp. Việc cắt bớt dữ liệu trong cửa sổ ngữ cảnh của agent cũng có thể là một vấn đề.

Việc triển khai MCP trong n8n hiện tại thực chất là chuyển đổi độ phức tạp từ việc xây dựng các node n8n riêng lẻ sang việc cấu hình và quản lý lớp MCP (servers, client node, biến môi trường). Điều này không phải lúc nào cũng đơn giản hơn, đặc biệt khi xem xét sự phụ thuộc vào các thành phần cộng đồng và những khó khăn cố hữu trong việc gỡ lỗi các hệ thống AI phân tán.

7. Bối cảnh So sánh: Định vị MCP trong các Tùy chọn Tích hợp AI của n8n

Để đưa ra quyết định chiến lược về việc sử dụng MCP trong n8n, điều quan trọng là phải so sánh nó với các phương pháp tích hợp AI khác có sẵn trên nền tảng.

7.1. MCP (qua n8n-nodes-mcp) vs. Native n8n Nodes-as-Tools

Đây là hai cách tiếp cận chính để cung cấp khả năng tương tác bên ngoài dưới dạng "công cụ" cho AI Agent node của n8n.

| Tính năng | MCP (qua n8n-nodes-mcp) | Native Nodes-as-Tools |

|---|---|---|

| Độ phức tạp Thiết lập | Cao hơn: Cài đặt node, cấu hình credential/server, bật cờ env | Thấp hơn: Chỉ cần thêm node được hỗ trợ vào agent |

| Độ rộng Hệ sinh thái | Tiềm năng rộng lớn: Truy cập mọi MCP server bên ngoài | Giới hạn: Chỉ các node n8n (core + community được bật) |

| Tiêu chuẩn hóa | Có: Tuân theo chuẩn MCP mở, đa nền tảng | Không: Chỉ dành riêng cho n8n |

| Ổn định / Hỗ trợ | Thấp hơn: Dựa vào community node | Cao hơn: Tính năng cốt lõi (thường là vậy) |

| Linh hoạt Phát triển | Cao: Server có thể viết bằng bất kỳ ngôn ngữ nào; hỗ trợ STDIO/SSE | Thấp hơn: Gắn với phát triển node n8n (JS/TS); gọi nội bộ |

| Tham số Động (từ AI) | Có: Thông qua input schema của tool | Có: Thông qua biểu thức $fromAI() |

| Trường hợp Sử dụng Lý tưởng | Truy cập tool chỉ có sẵn dưới dạng MCP server; ưu tiên chuẩn hóa; thử nghiệm | Tích hợp chức năng đã có sẵn trong node n8n; ưu tiên sự đơn giản, ổn định |

Native Nodes-as-Tools rõ ràng là con đường ít trở ngại nhất để tích hợp các chức năng đã tồn tại trong n8n vào AI agent. Nó tận dụng các node hiện có và quy trình làm việc quen thuộc của n8n. Ngược lại, MCP (thông qua community node) đóng vai trò như một cổng kết nối đến một hệ sinh thái công cụ bên ngoài, có khả năng rộng lớn hơn và được tiêu chuẩn hóa, nhưng đi kèm với sự phức tạp trong thiết lập, quản lý và phụ thuộc vào các thành phần không cốt lõi. Sự lựa chọn phụ thuộc vào việc công cụ cần thiết đã được tích hợp tốt vào n8n hay chủ yếu tồn tại trong hệ sinh thái MCP bên ngoài.

7.2. MCP (qua Agent) vs. Tích hợp Node LLM Trực tiếp

Người dùng n8n có thể gọi trực tiếp các LLM như Claude thông qua các node tích hợp sẵn (ví dụ: Anthropic Chat Model) hoặc node HTTP Request chung mà không cần sử dụng AI Agent node.

- Gọi LLM Trực tiếp:

- Đơn giản hơn cho các tương tác LLM đơn lẻ, được xác định trước trong workflow.

- Hoạt động theo mô hình yêu cầu-phản hồi đơn giản.

- Thiếu khả năng tự chủ, bộ nhớ dài hạn, hoặc khả năng tự động lựa chọn công cụ.

- Phù hợp cho các tác vụ AI cụ thể, được điều khiển bởi logic workflow (ví dụ: tóm tắt văn bản, dịch thuật, phân loại).

- MCP (qua AI Agent):

- Cho phép LLM hoạt động như một agent tự chủ hơn, có khả năng lý luận, lập kế hoạch, duy trì bộ nhớ và quyết định khi nào và làm thế nào để sử dụng các công cụ MCP dựa trên ngữ cảnh hội thoại.

- Phù hợp cho các nhiệm vụ phức tạp, động, đòi hỏi sự tương tác linh hoạt với các công cụ bên ngoài để hoàn thành mục tiêu.

Tóm lại, việc gọi LLM trực tiếp giống như sử dụng một hàm cụ thể trong code, trong khi sử dụng MCP với AI Agent giống như trao quyền cho một thực thể tự trị với một bộ công cụ để giải quyết vấn đề.

7.3. MCP vs. Tích hợp LangChain Tổng quát của n8n

Cần làm rõ rằng AI Agent node của n8n chính là một cách triển khai và trừu tượng hóa framework LangChain. Do đó, việc so sánh MCP với "AI Agent" thực chất là so sánh MCP với một trong những cách mà n8n phơi bày chức năng LangChain cho người dùng.

- MCP như một Tool Provider cho LangChain/Agent: MCP (thông qua nút n8n-nodes-mcp) không phải là đối thủ cạnh tranh mà là một nhà cung cấp công cụ tiềm năng cho các agent dựa trên LangChain của n8n. AI Agent node (trực quan) có thể được cấu hình để sử dụng MCP Client làm công cụ.

- LangChain Code Node: Node này cho phép người dùng viết code LangChain tùy chỉnh trực tiếp trong n8n, mang lại sự linh hoạt cao hơn so với AI Agent node trực quan. Về mặt lý thuyết, code tùy chỉnh này cũng có thể tương tác với các MCP server (ví dụ: bằng cách sử dụng SDK MCP hoặc gọi API trực tiếp).

- So sánh: Sự khác biệt chính không nằm ở MCP vs LangChain, mà là ở cách MCP được tích hợp vào các cách triển khai LangChain khác nhau của n8n:

- AI Agent Node (Visual): Trừu tượng hóa LangChain, dễ sử dụng hơn, có thể dùng MCP tools thông qua cấu hình node.

- LangChain Code Node (Code): Yêu cầu code, linh hoạt hơn, có thể tích hợp MCP tools thông qua code tùy chỉnh.

Như vậy, MCP đóng vai trò là một nguồn cung cấp công cụ được tiêu chuẩn hóa, có thể được tiêu thụ bởi các agent dựa trên LangChain của n8n, bất kể chúng được xây dựng thông qua giao diện trực quan hay code tùy chỉnh.

8. Kết luận và Khuyến nghị Chiến lược

Phân tích cho thấy Model Context Protocol (MCP) của Anthropic là một nỗ lực đầy tham vọng nhằm chuẩn hóa cách các ứng dụng AI tương tác với công cụ và dữ liệu bên ngoài, giải quyết vấn đề tích hợp phân mảnh hiện nay. Nền tảng tự động hóa n8n, với tính linh hoạt, khả năng mở rộng và hỗ trợ AI ngày càng tăng, cung cấp một môi trường tiềm năng để tích hợp và tận dụng MCP.

Việc tích hợp MCP vào n8n chủ yếu dựa vào community node n8n-nodes-mcp, cho phép các workflow và AI Agent của n8n hoạt động như một MCP client, tương tác với các MCP server bên ngoài. Lợi ích chính của cách tiếp cận này là khả năng truy cập vào một hệ sinh thái công cụ tiềm năng rộng lớn tuân theo chuẩn MCP, vượt ra ngoài các tích hợp gốc của n8n.58 Xu hướng mới nổi về việc sử dụng n8n như một MCP server cũng mở ra tiềm năng biến n8n thành nhà cung cấp dịch vụ AI-callable được tiêu chuẩn hóa.

Tuy nhiên, việc triển khai MCP trong n8n hiện tại đi kèm với những thách thức đáng kể. MCP là một giao thức mới, hệ sinh thái còn non trẻ và việc áp dụng rộng rãi chưa chắc chắn.11 Việc tích hợp phụ thuộc vào community node, tiềm ẩn rủi ro về ổn định và hỗ trợ.13 Quá trình thiết lập và quản lý (đặc biệt là MCP server) làm tăng độ phức tạp vận hành.13 Gỡ lỗi các hệ thống phân tán này vốn đã khó khăn. Hơn nữa, n8n đã phát triển cơ chế "Nodes as Tools" của riêng mình, cung cấp một giải pháp thay thế đơn giản và tích hợp hơn cho việc sử dụng các chức năng đã có sẵn trong n8n làm công cụ cho AI Agent, cạnh tranh trực tiếp với lý do sử dụng MCP cho nhiều trường hợp.

Khuyến nghị Chiến lược cho các Nhóm Kỹ thuật sử dụng n8n:

- Ưu tiên Native Options khi Có thể:

- Đối với việc tích hợp các công cụ hoặc dịch vụ đã có sẵn dưới dạng node n8n ổn định và được hỗ trợ làm công cụ agent (thông qua "Nodes as Tools"), đây thường là lựa chọn đơn giản, ổn định và được hỗ trợ tốt nhất.

- Đối với các tác vụ AI cụ thể, không yêu cầu khả năng tự chủ phức tạp của agent, hãy xem xét việc gọi trực tiếp các node LLM (Anthropic, OpenAI, v.v.) hoặc HTTP Request.

- Xem xét MCP khi:

- Cần truy cập Công cụ Chuyên biệt: Khi công cụ cần thiết chỉ có sẵn dưới dạng MCP server và không có sẵn dưới dạng node n8n đáng tin cậy.

- Ưu tiên Tiêu chuẩn hóa Đa nền tảng: Nếu dự án yêu cầu khả năng tương tác với các ứng dụng hoặc hệ thống AI khác cũng tuân thủ MCP, hoặc nếu có chiến lược dài hạn về việc áp dụng tiêu chuẩn này.

- Thử nghiệm và Khám phá: Để thử nghiệm các giao thức tích hợp AI mới nhất và đánh giá tiềm năng của hệ sinh thái MCP.

- Thực hành Tốt nhất khi Sử dụng MCP trong n8n:

- Bắt đầu Nhỏ và Kiểm thử Kỹ lưỡng: Triển khai với một hoặc hai MCP server đơn giản trước khi mở rộng.

- Quản lý Phụ thuộc và Bảo mật: Hiểu rõ cách MCP server được khởi chạy (STDIO) hoặc quản lý (SSE). Đảm bảo cấu hình bảo mật phù hợp cho cả server và credentials trong n8n.

- Theo dõi Community Node: Theo dõi sự phát triển, các vấn đề và cập nhật của nút n8n-nodes-mcp mà bạn đang sử dụng. Cân nhắc đóng góp nếu có thể.

- Thiết kế Prompt Rõ ràng: Cung cấp hướng dẫn chi tiết và mô tả công cụ rõ ràng cho AI Agent để đảm bảo việc lựa chọn và sử dụng MCP tools đáng tin cậy.

- Chuẩn bị cho Gỡ lỗi: Nhận thức được sự phức tạp trong việc gỡ lỗi và chuẩn bị các công cụ hoặc phương pháp để theo dõi yêu cầu qua các lớp khác nhau.

- Theo dõi Tương lai:

- Quan sát sự phát triển và mức độ áp dụng của cả giao thức MCP và các tính năng AI gốc của n8n.

- Đánh giá tiềm năng của việc sử dụng n8n như một MCP server nếu phù hợp với kiến trúc hệ thống của bạn.

Kết luận:

Quyết định sử dụng MCP trong n8n ngày nay là một sự đánh đổi chiến lược. Nó mang lại cơ hội tiếp cận một tiêu chuẩn tiềm năng và một hệ sinh thái công cụ rộng lớn hơn, nhưng phải trả giá bằng sự phức tạp gia tăng, sự phụ thuộc vào các thành phần cộng đồng và những thách thức về độ trưởng thành. Đối với nhiều trường hợp sử dụng, các tính năng tích hợp AI gốc của n8n, đặc biệt là "Nodes as Tools", cung cấp một giải pháp thay thế đơn giản và ổn định hơn hiện nay. Việc lựa chọn phụ thuộc vào các công cụ cụ thể cần thiết, mức độ ưu tiên cho tiêu chuẩn hóa so với sự đơn giản tích hợp và khả năng chấp nhận rủi ro và độ phức tạp của nhóm kỹ thuật.